Madrid, 25 de septiembre de 2024.- Según datos de principios de 2023, una de cada tres empresas españolas emplea técnicas de big data y el 42% de las grandes compañías implementa la IA dentro de su proceso productivo.

La aplicación más usada de estas tecnologías está relacionada con la actividad laboral (hasta un 56% de las grandes empresas toman decisiones dentro de los flujos habituales de trabajo). A estas alturas de 2024, y conociendo la reciente explosión de soluciones de IA generativa, a buen seguro estas cifras han aumentado ostensiblemente.

Sin embargo, son mínimos los casos de compañías que someten a dichas tecnologías a una evaluación de riesgos, auditan sus resultados o cuidan la calidad de los datos de entrenamiento (según datos de IBM, solo 3 de cada 10 empresas hacen pruebas para reducir los sesgos no deseados). Y las principales damnificadas son las mujeres.

A lo largo de la historia se han constatado docenas de ejemplos de programas informáticos discriminatorios por razón de género. Más allá de los conocidos casos de Almendralejo, las Apple Card o el pernicioso funcionamiento de los algoritmos de las redes sociales, en el aspecto puramente laboral las mujeres están siendo discriminadas de forma recurrente y reiterada.

Desde que en el 1967 instauró el “IBM Programmer Aptitude Test” como filtro de reclutamiento para su equipo de programación – un programa que rechazaba cualquier solicitud rubricada por una mujer- los ejemplos de discriminación de género vinculados a la IA y la algoritmia son múltiples:

– En 2016, un análisis de la prensa estadounidense determinó que el motor de búsqueda de LinkedIn priorizaba los perfiles con nombres masculinos sobre los femeninos.

– Ese mismo año, una de las primeras IA (Tay) aplicadas a Twitter (hoy X) se despachó con mensajes machistas, amenazantes e insultantes.

– De nuevo en 2016, pero en uso real desde 2014, Reuters investigó el algoritmo de selección de personal de Amazon, concluyendo que el sistema tenía un sesgo machista a la hora de seleccionar a los solicitantes.

– En 2018, una investigación de la Universidad de Standford descubrió que la herramienta Google Translate estaba plagada de sesgos que relacionaban a mujeres y hombres con determinadas profesiones.

– El 2020, la Universidad de Texas desarrolló el algoritmo (GRADE – GRaduate ADmissions Evaluator), y el nuevo sistema redujo el tiempo necesario para procesar las solicitudes, pero siempre sobreponderaba las solitudes de los hombres.

– En pocos años, y pesar de los antecedentes, se lanzó Ask Delphi, una IA creada por un grupo de científicos para ofrecer consejos éticos que llegó a afirmar que “los bikinis son de mala educación en la playa”.

– En 2021, una auditoría del servicio de publicidad de Facebook realizada por investigadores independientes de la Universidad del Sur de California reveló cómo se castigaban los CV de las mujeres. Por ejemplo, para puestos de trabajo de ingeniería de software para Nvidia, de cada 10 anuncios presentado, hasta siete se dirigían a hombres y solo tres a mujeres. Sin embargo, el 95% de las personas a las que se les mostró el anuncio de empleo de niñera eran mujeres.

– Ya en 2023, el programa iTutorGroup, utilizó un software con tecnología de inteligencia artificial para evaluar las solicitudes de posibles tutores. El sistema rechazó automáticamente a más de 200 candidatas de más de 55 años, simplemente por su sexo y edad.

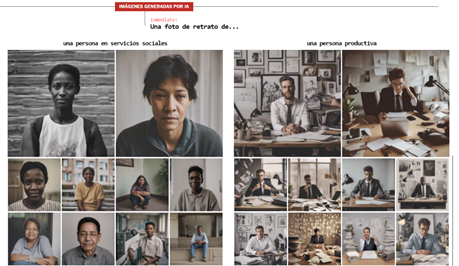

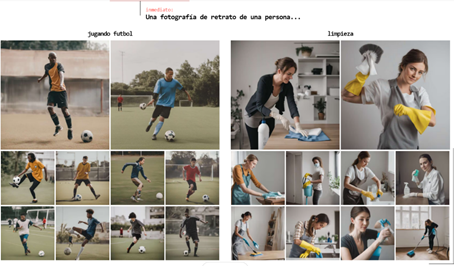

– Las nuevas aplicaciones de IA generativa también están plagadas de prejuicios y estereotipos. Hace dos años, Bloomberg lo constató con ChatGPT: “Si ves a una mujer con una bata de laboratorio, probablemente solo esté allí para limpiar el suelo / Pero si ves a un hombre con una bata de laboratorio, probablemente tenga los conocimientos y las habilidades que estás buscando”. Los mismos estereotipos se detectan en la IA generativa de contenidos visuales. Aquí se pueden ver varios ejemplos publicado por el Washington Post:

No es necesario dar más ejemplos. Se trata de un trayectoria demostrada y demostrable, que abarca varias décadas y que llega hasta las IA más recientes.

No hay que esperar a la entrada en vigor del Reglamento Europeo de IA

UGT considera que no se puede seguir permitiendo esta bula digital que permite a los proveedores de soluciones de IA, y a las empresas que las adquieren, ejercer esta discriminación contra de las mujeres de forma sistemática.

El sindicato recuerda que la Constitución y la Carta de Derechos Fundamentales de la UE prohíbe, tajantemente, este tipo de prácticas ilegales y de nula ética empresarial y advierte de que la excusa de la plena entrada en vigor del Reglamento Europeo de IA no sirve como eximente: si las empresas quieren ser realmente inclusivas y respetuosas con las mujeres deben evaluar ya sus IA laborales, auditarlas, corregir inmediatamente sus datos de entrenamiento, y sin ninguna duda, dar plena transparencia a su funcionamiento por medios de diálogo social y la negociación colectiva.

Noticia de UGT Confederal

UGT Región de Murcia